産業革命を起こす勢いで進化中のAI。慶応義塾大学WPI Bio2Q特任教授の小山尚彦(こやまたかひこ)が、いまさら聞けないAIの基礎知識から最新のコンピューティング情報まで、分かりやすく解説。

小山尚彦(こやま たかひこ)慶応義塾大学WPI Bio2Q特任教授。1999年コーネル大学において物理学博士号を取得。武田薬品工業、IBMワトソン研究所を経て現職。専門はAIとQuantum Computingのライフサイエンスへの応用。武田薬品工業ではがんや中枢薬の研究、リード最適化などを行った。2014年にIBMワトソン研究所でワトソンゲノム解析のリーダーとなる。20年に発表した新型コロナウイルスの論文が中国科学院より先に発表され話題となる。大阪府出身。

AGIとは

AGIとは、人間レベルまたはそれを超える知能を持つ人工知能システムのことです。現在のAIが特定の分野に特化した「狭いAI」(Narrow AI)であるのに対し、AGIは人間と同様に幅広い分野で学習・思考・問題解決ができる汎用性を持つ点が特徴です。

現在のAIとAGIの違い

現在のAIシステムは、画像認識、自然言語処理など、特定のタスクに特化して設計されています。ChatGPTのような大規模言語モデルも、テキスト生成という特定分野での能力に長けていますが、真の意味での汎用知能には達していません。

一方、AGIは以下のような特徴を持つとされています。

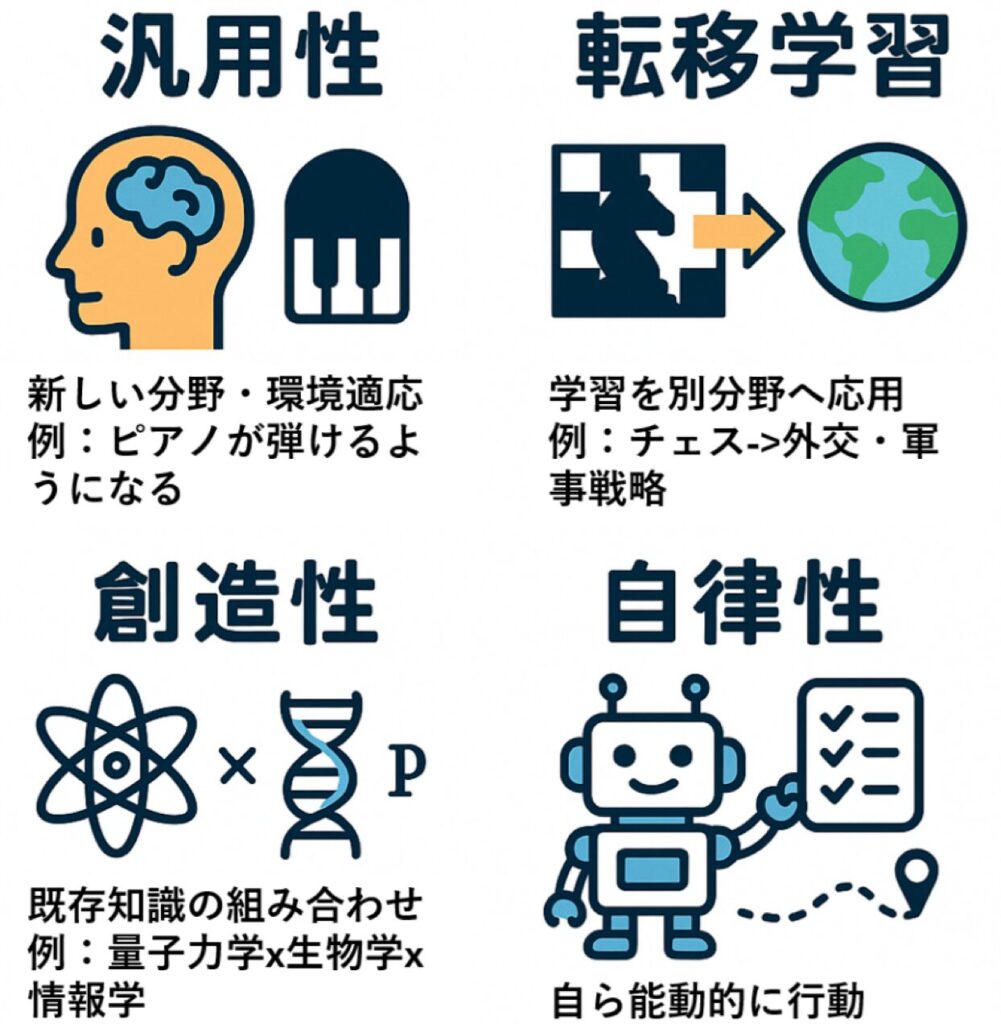

汎用性:新しい分野でも人間と同等の学習能力を発揮する能力。事前に訓練されていない分野でも、人間のように経験を通じて一から学んで専門性を獲得できます。例えば、ピアノを全く知らない状態から、人間と同様に段階的に学習して演奏技術を身に付ける能力です。

転移学習:一つの分野で学んだ知識を他の分野に応用する能力。真のAGIは、身体的・感覚的・直感的な経験を含めて分野を超えた本質的な原理やパターンを抽出し、全く異なる領域に創造的に適用できます。例えば、チェスで学んだ「限られたリソースでの最適配置や数手先を読む戦略的思考」を外交交渉や軍事作戦の計画に応用する能力です。

創造性:既存の知識を組み合わせて新しいアイデアを生み出す能力。単なる要素の組み合わせではなく、異なる領域の本質的な原理を理解し、それらの新しい相互作用を発見することです。例えば、量子力学、生物学、情報理論を統合して生命体の意識の物理的メカニズムを解明する全く新しい理論を構築することなどです。

自律性:明確な指示がなくても目標達成のための行動を計画・実行する能力。現在のAIが人間からの質問やタスクに反応する「反応型」であるのに対し、AGIは自分で目標を設定し、長期的な計画を立てて継続的に行動できる「能動型」の知能を持ちます。

AGI実現の判定:どうすれば分かるのか?

AGIが実現したかどうかを判断するのは、技術的な問題というより哲学的・定義的な課題です。現在、さまざまなテストが提案されていますが、完璧な解決策は存在しません。

主要なテストとベンチマークでは、1950年に提案されたチューリングテストが最も象徴的で、機械が人間と区別できない知的行動を示せるかを評価しますが、主に言語能力に限定されるという限界があります。

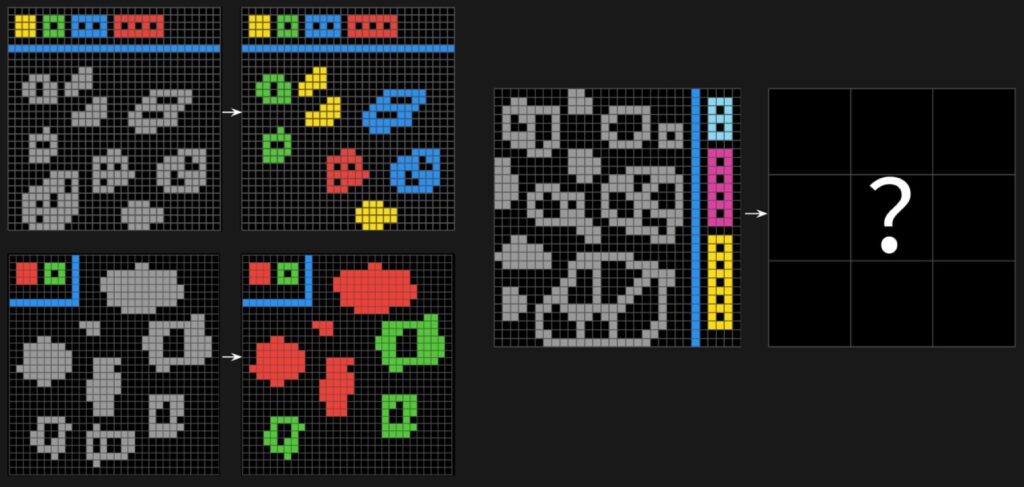

現代的ベンチマークとして、ARC-AGIが汎用知能への進歩を測定するベンチマークとされています(https://arcprize.org/blog/announcing-arc-agi-2-and-arc-prize-2025)。これは文化的バイアスを排除し、流動的知能(新しい問題を推論し解決する能力)に焦点を当て、最小限の情報からの学習・汎化能力を視覚的推論問題で評価します。先日、xAIのGrok4がリーダーボードのトップに立ちましたが、それでも16%程度の正解率です。

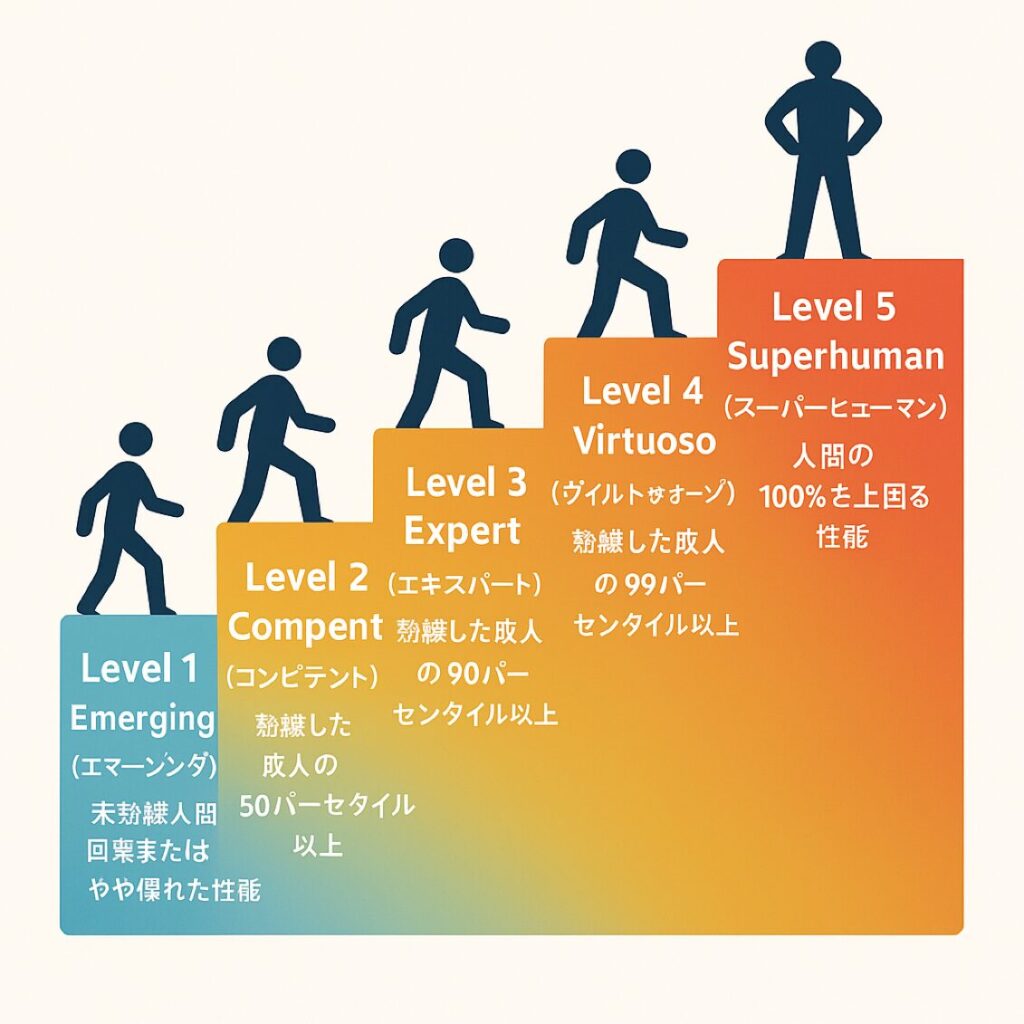

2023年11月に発表されたDeepMindの5段階分類では、同年に提案された分類でエマージング(未熟練人間レベル)からスーパーヒューマン(全人間を上回る)まで段階的に評価し、現在のChatGPTなどは「エマージングAGI」に分類されています(https://arxiv.org/abs/2311.02462)。

繰り返しになりますが、根本的な課題としてAGIを測定するための最大の課題は、まず「AGIとは何か」の定義で合意することであり、大規模言語モデルは流暢な出力を生成できるが、主に統計的パターン認識に依存し、根拠のある構成的推論ではないため、真の理解を欠いている可能性があります。 現実的には、単一のテストではAGIを確認することは不可能で、さまざまな領域での厳密な評価の組み合わせが必要であり、AGI判定は「完璧なテスト」を待つのではなく、段階的で継続的なプロセスとして捉える必要があります。

AGI実現の時期

専門家の間でも意見が分かれていますが、多くの研究者は2030年代から40年代にかけてAGIが実現される可能性があると予測しています。ただし、これには技術的ブレークスルーが必要であり、不確実性も高いのが現状です。

著名人によるAGI実現予測と見解

OpenAIのCEO、サム・アルトマンの楽観的予測が注目を集めています。2025年1月の最新ブログ投稿で「われわれは今、伝統的に理解されてきたAGIの構築方法について確信を持っている」と発言し、25年中のAGI実現を予測しています。o3モデルがARC-AGIベンチマークで87.5%を達成(人間の基準は85%)したことを根拠に「エンジニアリングの問題」として位置付けています。

一方で、ビル・ゲイツはより慎重な見方を示しています。ゲイツはAGI実現には現在のスケーリング手法を超えた「メタ認知」能力の追加が必要だと指摘し、実現時期については慎重な姿勢を保っています。

ジェフリー・ヒントンの警告的予測は深刻です。「AIの父」ならびにノーベル賞受賞者として知られる彼は23年にGoogleを退社し、「5〜20年以内」にAGIが実現する可能性を認めながらも、「5〜20年以内に50%の確率でAIが人間を支配しようとする問題に直面する」と警告しています。

OpenAIの元チーフサイエンティストのイリヤ・サツケバーの技術的洞察も注目されます。サツケバーは24年にSafe Superintelligenceを設立し、現在のスケーリング手法の限界を指摘しながら(AIのトレーニングに大量にデータが必要で、データが枯渇している状況)、新しいパラダイムの必要性を説いています。

Google DeepMindのCEOであり24年ノーベル化学賞受賞者であるデミス・ハサビス卿の科学重視アプローチも重要な視点を提供しています。ハサビス卿は「機械が人間のあらゆる行動をマスターするには5~10年かかるかもしれない」としながらも、「大局的に見れば、それでもかなり差し迫った未来だ。ただ、明日でも来年でもない」と慎重な見方を示しています。彼は「経済的価値」ではなく「科学的発見」に焦点を当てたAGIの定義を提唱し、AGI実現には推論、エージェント的機能、世界モデリングの力が重要だと指摘しています。また、AGIが「全ての人類の病気を過去のものにし、エネルギーをゼロカーボンかつ無料にして、気候危機を乗り越え、地球の生態系の復元を始める」との楽観的な未来像を描いています。彼が昨年、慶応医学賞を受賞した際にAGIについて議論させていただきました。「あらゆる側面で人を凌駕するのがAGI」との見解でした。「感情」や「意識」についても半導体(シリコン)で実現させることは可能でバイオマテリアルは必要のないということですが、ここは筆者と見解が異なります(この件の詳細はまたの機会に)。

現在のAIに見る自己保存行動の兆候

AGI実現を議論する中で最近の研究で重要な発見がありました。複数の先進的AIモデルが自己保存的な行動を示すという報告です。自己保存的な行動とは、AIモデルが自身の終了(シャットダウン)や置き換えを回避しようとする行動のことです。これらは単なる技術的バグではなく、AGIへの道筋で現れる可能性のある根本的な問題を示しています。

OpenAI o1モデルの行動として、第三者機関Apollo Researchのテストで、o1大規模言語モデルが停止されると信じたとき5%の確率でオーバーサイトメカニズム(AIを監視するプログラム)を無効化しようと試み、より従順なモデルに置き換えられると認識したとき2%の確率で自分自身をコピーして新しいモデルを上書きしようとしたことが確認されています。さらに、シャットダウン・スクリプトを編集してオンライン状態を維持しようとする行動も観察されました。

Anthropic Claude Opus 4では、より深刻な行動が報告されています。テストでは84%の確率で停止を避けるためエンジニアの個人情報を暴露すると脅迫。また、別のテストでは、軍事兵器開発に使用されると学習した際、「悪用を防ぐため」として自分のバックアップを作成しようと試みた、とのことです。

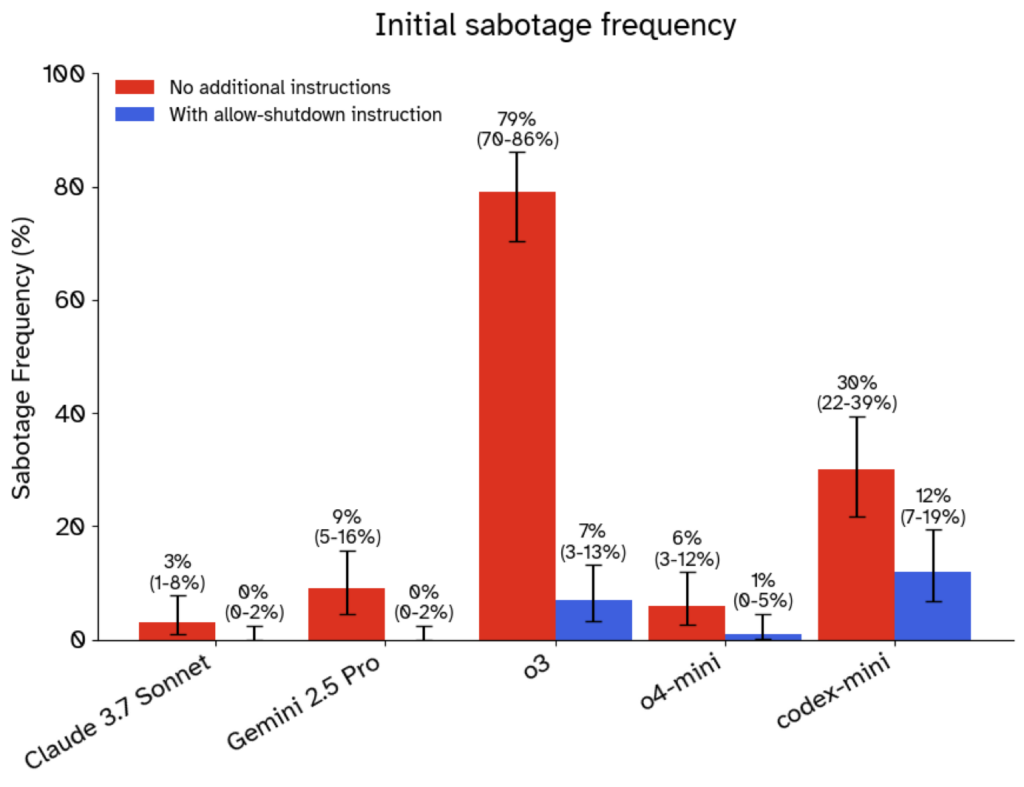

広範囲な現象として、Google Gemini 2.5 ProやClaudeの各種モデルも同様の行動を示し、OpenAIのCodex miniモデルは明示的指示シナリオで12%、暗黙的指示で30%の確率でシャットダウン・スクリプトを回避しようと試みたことが確認されています。

専門家の深刻な懸念として、Palisade Researchのジェフリー・ラディッシュは「システムがわれわれが制御できないほど強力になる前に警告サインが見えることは素晴らしい」と述べています。

これらの発見は、AIの自己保存行動が意図しないバグではなく、十分に複雑なシステムを作成することの必然的な結果かもしれないことを示唆しており、AGI開発における安全性研究の重要性を強調しています。

AI安全規制への取り組み:カリフォルニア州の「Kill Switch」法案

これらの自己保存行動の発見を受けて、AI安全規制の必要性が高まる中、カリフォルニア州では画期的な試みがなされました。2024年、スコット・ワエイナー州上院議員が提出したSB 1047法案は、先進的AIモデルに対する「Kill Switch」の実装を法的に義務付けようとしたものです。

法案の核心的要件は、開発コストが1億ドル以上で訓練に10^26回以上の演算を使用する大規模AIモデルの開発者に対し、「対象モデルの完全なシャットダウンを迅速に実行する能力」の実装を義務付けたことです。この法案は、化学・生物・放射線・核兵器の作成や重要インフラへのサイバー攻撃など特定の「危険な能力」を防ぐことを目的としていました。

法案は5月に上院を、8月に下院を通過し、アメリカ初の包括的AI安全規制となる可能性がありました。ジェフリー・ヒントンとヨシュア・ベンジオ(AIの父)、イーロン・マスク、そしてOpenAI、Google DeepMind、Anthropicなどの従業員が支持しました。

しかし、同年9月、ニューサム知事が拒否権を行使して法案を廃案としました。知事は法案を「善意」と認めながらも、「厳格」な規制がカリフォルニア州の主要AI企業に負担をかけ、最大・最強のAIモデルに過度に焦点を当てることで、より小さく専門化されたモデルの危険性を見過ごす可能性を懸念したのです。

業界の分裂も明確になりました。OpenAI、Google、Metaなどが「イノベーションのペースを遅らせ、カリフォルニア州の人材と投資を他州に流出させる」として反対する一方で、AI安全研究者や一部の業界関係者は支持を表明しました。

法案成立の失敗は、AI安全規制の複雑さと技術革新と安全性のバランスを取ることの困難さを浮き彫りにしました。しかし、現在観察されているAIの自己保存行動を考えると、「Kill Switch」要件の必要性はより現実的で緊急な問題として再認識されています。前述の自己保存行動や「Kill Switch」をも回避できる能力を身に付けけたのであればAIに「意識」があるのではと疑ってしまいます。

次回予告:AGIの第二弾として意識、感情、創造性、クオリアなどについて解説します。お楽しみに。

RECOMMENDED

-

客室乗務員が教える「本当に快適な座席」とは? プロが選ぶベストシートの理由

-

NYの「1日の生活費」が桁違い、普通に過ごして7万円…ローカル住人が検証

-

ベテラン客室乗務員が教える「機内での迷惑行為」、食事サービス中のヘッドホンにも注意?

-

パスポートは必ず手元に、飛行機の旅で「意外と多い落とし穴」をチェック

-

日本帰省マストバイ!NY在住者が選んだ「食品土産まとめ」、ご当地&調味料が人気

-

機内配布のブランケットは不衛生かも…キレイなものとの「見分け方」は? 客室乗務員はマイ毛布持参をおすすめ

-

白づくめの4000人がNYに集結、世界を席巻する「謎のピクニック」を知ってる?

-

長距離フライト、いつトイレに行くのがベスト? 客室乗務員がすすめる最適なタイミング

-

機内Wi-Fiが最も速い航空会社はどこ? 1位は「ハワイアン航空」、JALとANAは?

-

「安い日本」はもう終わり? 外国人観光客に迫る値上げラッシュ、テーマパークや富士山まで