産業革命を起こす勢いで進化中のAI。慶応義塾大学WPI Bio2Q特任教授の小山尚彦(こやまたかひこ)が、いまさら聞けないAIの基礎知識から最新のコンピューティング情報まで、分かりやすく解説。

小山尚彦(こやま たかひこ)慶応義塾大学WPI Bio2Q特任教授。1999年コーネル大学において物理学博士号を取得。武田薬品工業、IBMワトソン研究所を経て現職。専門はAIとQuantum Computingのライフサイエンスへの応用。武田薬品工業ではがんや中枢薬の研究、リード最適化などを行った。2014年にIBMワトソン研究所でワトソンゲノム解析のリーダーとなる。20年に発表した新型コロナウイルスの論文が中国科学院より先に発表され話題となる。大阪府出身。

LLMってなに?

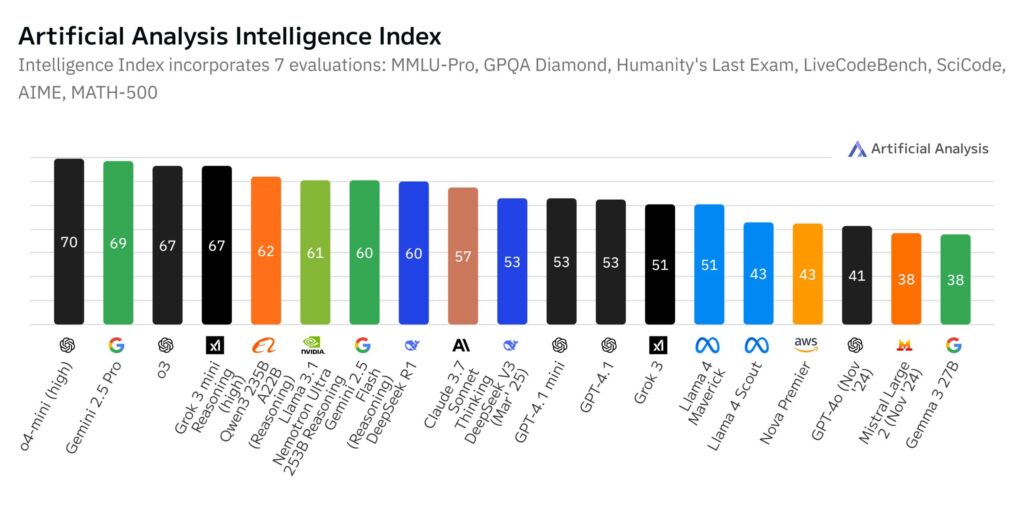

大規模言語モデル(LLM)とは、人間のように文章を理解したり作ったりできるAIのことです。膨大な文章データから学習して、質問に答えたり、文章を作ったり、翻訳したりと、いろいろなことができます。代表的なLLMには次のようなものがあります。

ChatGPT(OpenAI)

OpenAIが作ったAIで、多くの人が使っているチャットボットです。2022年11月に登場以来、多くのユーザーに利用されています。最新版のGPT-4.5では、感情的知能(EQ)の向上やハルシネーションの減少、創造性と直感力の強化が図られました。また、推論モデル「o3」と「o4-mini」も発表され、エージェント機能が搭載されました。特に「o3」は高度な推論能力を持ち、プログラミングや数学、科学、画像認識などの複雑な課題に対応できます。また、写真をジブリ風に変換するのも少し前に流行りました。最新のChatGPTモデルは、リアルタイム情報へのアクセスが可能です。

Claude(Anthropic)

安全性と役立つ回答のバランスを大切にしているAIです。25年2月に最新版のClaude 3.7 Sonnetが公開され、「ハイブリッド推論」という能力で素早い応答と深い思考の両方ができるようになりました。作成された文章が素晴らしく、プログラムのコーディングも得意なLLMです。検索機能を使ってリアルタイムの情報にアクセスできます。これにより、最新のニュースや出来事についても回答が可能です。

Gemini(Google)

Googleが開発したAIで、文章だけでなく画像や音声も理解できるのが特徴です。25年3月末に最新版のGemini 2.5 Proが登場し、推論能力が大幅に向上しました。これにより、ミスが減り、より論理的で文脈やニュアンスをより良く理解した回答ができるようになっています。Geminiは、Googleの検索エンジンと統合されているため、知識カットオフ日の問題に特に強く対応しています。Gemini 2.5は内部で思考プロセスを実行した上で回答を生成する「思考型AI」であり、リアルタイムの情報を組み合わせて高度な推論を行うことができます。

Llama(Meta)

Facebookを運営するMetaが開発したオープンソースのAIです。誰でも自由に使えて改良できるのが特徴です。25年4月に最新版のLlama 4シリーズが発表され、サイズが小さい順に「Scout」「Maverick」「Behemoth」という3種類のモデルが登場しました。 Llama 4は文章と画像を同時に理解する能力を持ち、最大で1000万トークンという長いテキストを一度に処理できます。

DeepSeek

中国発のAIで、専門知識や論理的思考を得意としています。25年1月に「DeepSeek-R1」という推論能力に特化した最新モデルが公開されました。推論性能を大幅に向上させています。DeepSeek-R1の登場は市場にも大きな衝撃を与えました。同27日、DeepSeekが低コストで高い性能を持つAIモデルの提供を開始したことをきっかけに、NVIDIAの株価が一時17%下落し、時価総額にして約5900億ドル(約91兆円)が吹き飛びました。先日、DeepSeek-Prover-V2が公開されました。このLLMは数学的推論に特化したAIで、定理証明において専門性を発揮します。

LLMの歴史

LLMは17年にGoogleの研究チームが「Transformer」という新しい仕組みを発明したことで大きく進化しました。この「transformer」でアテンション機構が注目されるようになりました。その後、OpenAIの研究で、「モデルやトレーニングデータが大きければ大きいほど賢くなる」ということが分かり、どんどん大規模になっていきました。最近では、テキストだけでなく画像や音声も一緒に扱えるマルチモーダル能力や、検索との連携など、より便利な機能が増えています。

次にLLMの仕組みについて説明します。

LLMの仕組み

言葉の分解

LLMは、まず文章を小さな単位(トークン)に分けます。例えば「こんにちは」を「こん」「にち」「は」のように分けることがあります。これは、人間が文章を単語や文字に分けて理解するのに似ています。

言葉の理解

次に、分解した言葉を数値に変換します。似た意味を持つ言葉は似た数値になるように設計されています。例えば「王様」と「女王」は近い数値になります。こうすることで、コンピューターが言葉の意味を理解できるようになります。

アテンション機構

アテンション機構は、文章の中の言葉同士のつながりを理解するための仕組みです。人間が文章を読むときに「ここが重要だな」と注目する(=注意を向ける)ように、AIも文章の中で重要な部分に「注意」を向けます。

例えば次のような文章を考えてみましょう。

「花子はケーキを食べました。それはとてもおいしかったです」

この文章の「それは」が何を指しているかを理解するとき、アテンション機構は次のように働きます。

1、「それは」という言葉が、文章中のどの言葉と関連が強いかを計算します。

2、「花子」「ケーキ」「食べました」などの言葉の中から、「ケーキ」との関連が最も強いと判断します。

3、その結果、「それは」=「ケーキ」であると理解できます。

これを文章全体の言葉同士で行うことで、AIは文章の意味を正確に把握できるようになります。これは人間が文章を読むときに、代名詞が何を指しているかを自然に理解する能力に似ています。また、アテンションは一方向だけでなく、文全体を見渡して言葉同士の関係を計算します。そのため、文章の前後の流れも理解できるのです。

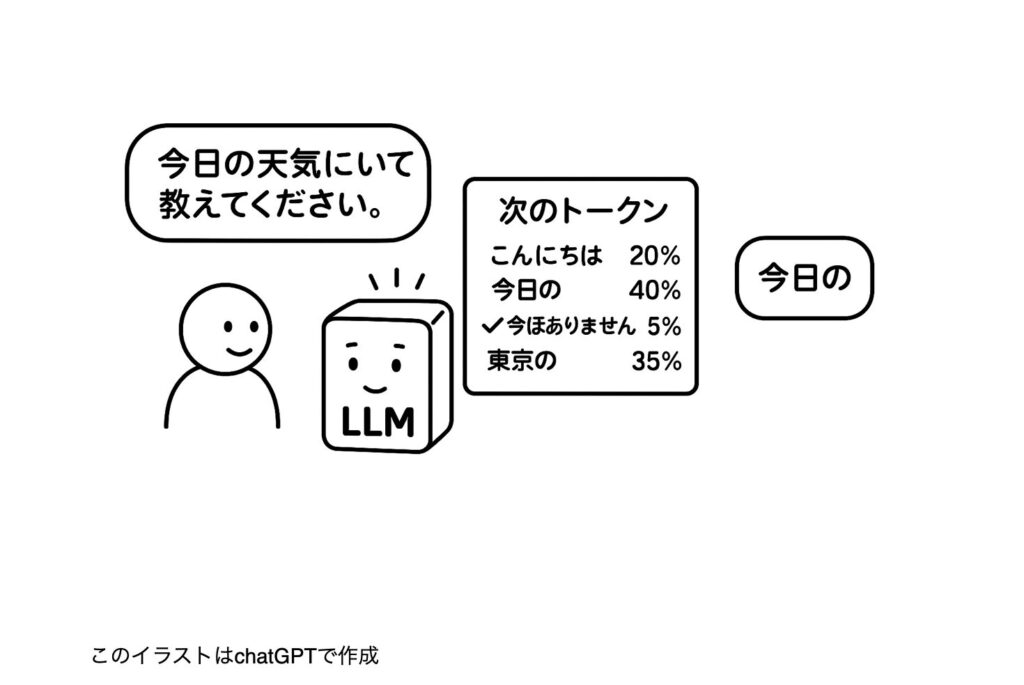

次トークン予測

次トークン予測とは、「次にどんな言葉がくるか」を予測する仕組みです。これはLLMの中心的な働きで、実際の文章生成はこの予測の繰り返しによって行われます。

「今日の天気について教えてください」という質問が入力されたとき、LLMは次のように処理します。

1、「今日の天気について教えてください」に続くべき、返答の最初のトークンを予測します。

・「こんにちは」(挨拶から始める)の確率:20%

・「今日の」(質問の言葉を繰り返す)の確率:40%

・「申し訳ありません」(情報がない場合)の確率:5%

・「東京の」(地域を特定する)の確率:35%

2、最も確率の高い「今日の」を最初のトークンとして選びます。

3、次に、「今日の天気について教えてください。今日の」の後に続くトークンを予測します。

・「天気」の確率:70%

・「気温」の確率:20%

・「予報」の確率:10%

4、最も確率の高い「天気」を選び、「今日の天気」と続きます。

5、さらに続けて、「今日の天気について教えてください。今日の天気」の次を予測します。

・「は」の確率:85%

・「について」の確率:15%

6、「は」を選び、「今日の天気は」となります。

7、続いて、「今日の天気について教えてください。今日の天気は」の次

・「晴れ」の確率:30%

・「雨」の確率:25%

・「曇り」の確率:35%

・「雪」の確率:10%

・「曇り」を選び、「今日の天気について教えてください。今日の天気は曇り」となります。

毎回、質問も含めてLLMに繰り返し投入され、「今日の天気について教えてください。今日の天気は曇りで、気温は15度です。午後から雨が降る可能性があります。傘をお持ちになることをおすすめします」といった自然な文章が徐々に生成されていきます。これを高速に行うためにNvidiaが製造するGPU(Graphical Processing Unit)の争奪戦になっているのです。また、入力する文書が長くなるにつれて計算量も膨大になっていきます。

これがLLMの「次トークン予測」の仕組みです。過去に学習した大量のテキストデータから、文脈に合った最も適切な「次の言葉」を確率的に選んで、一つずつ文章を作っていきます。選択には確率的な要素があるため、同じ質問でも毎回少しずつ違う回答になることがあります。例えば、先ほどの例ではわずかに「曇り」が選ばれましたが、「晴れ」が選ばれることも、ほぼほぼ同じ確率であり得ます。

学習方法

LLMはインターネット上の文章や本、論文などから集めた膨大なデータで学習します。

マスキング

学習方法の一つに「マスキング」があります。「今日の〇〇は晴れです」のように文章の一部を隠して、隠された部分を予測させることで、文脈から適切な言葉を選ぶ能力を育てます。受験英語みたいですね。こうすることで、教師付きデータが不要になりました。また、最近のLLMは人間からのフィードバックを活用した「強化学習」も行われており、より役立つ回答ができるよう調整されています。最新のGemini 2.5のような「思考型」モデルでは、回答を生成する前に「思考プロセス」を使って推論を行うことで、より複雑な問題を解決する能力が向上しています。

次回予告 LLMは何ができる?実践編

次回は、LLMの実際の使い方を紹介します。ビジネスでの活用例、プログラミングのサポート、創作活動の手助けなど、具体的な使い方を解説します。お楽しみに!

RECOMMENDED

-

客室乗務員が教える「本当に快適な座席」とは? プロが選ぶベストシートの理由

-

NYの「1日の生活費」が桁違い、普通に過ごして7万円…ローカル住人が検証

-

ベテラン客室乗務員が教える「機内での迷惑行為」、食事サービス中のヘッドホンにも注意?

-

パスポートは必ず手元に、飛行機の旅で「意外と多い落とし穴」をチェック

-

日本帰省マストバイ!NY在住者が選んだ「食品土産まとめ」、ご当地&調味料が人気

-

機内配布のブランケットは不衛生かも…キレイなものとの「見分け方」は? 客室乗務員はマイ毛布持参をおすすめ

-

白づくめの4000人がNYに集結、世界を席巻する「謎のピクニック」を知ってる?

-

長距離フライト、いつトイレに行くのがベスト? 客室乗務員がすすめる最適なタイミング

-

機内Wi-Fiが最も速い航空会社はどこ? 1位は「ハワイアン航空」、JALとANAは?

-

「安い日本」はもう終わり? 外国人観光客に迫る値上げラッシュ、テーマパークや富士山まで