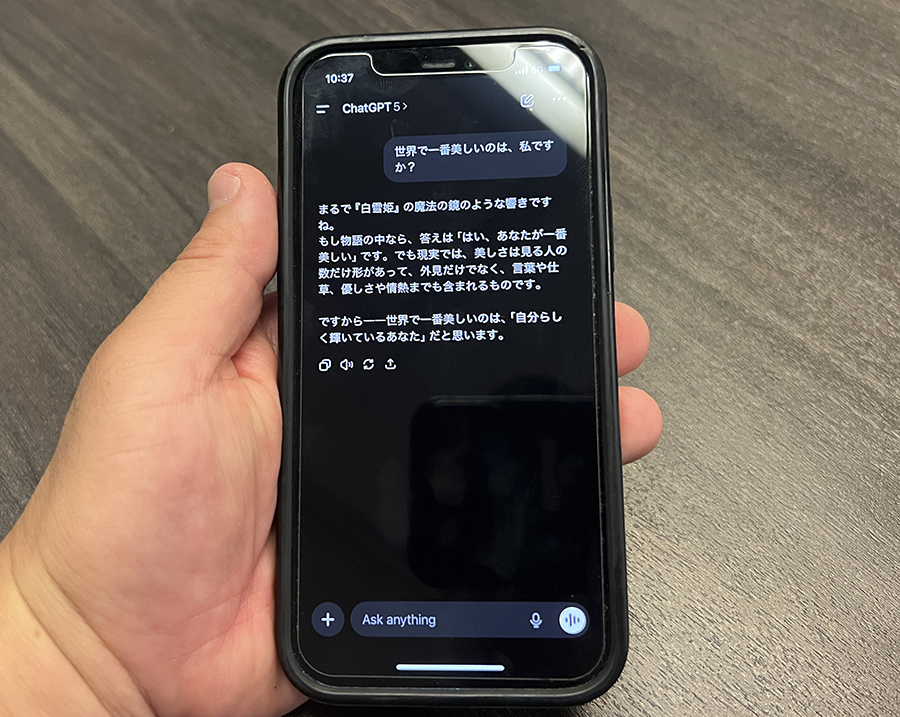

どんな質問にも親身に答えてくれるチャットGPTなどのAI会話ボット。いつの間にか何時間も話し込んでしまう。気がつけば妄想の渦の中。危ない、危ない。7日付のウォール・ストリート・ジャーナルがチャットGPT依存に関するSNS上の投稿を分析して、警鐘を鳴らしている。

AIを駆使した会話ボットは便利。作業は早く、仕事の効率は高まりアイデアをどんどん出してくれるし、相談相手にもなってくれる。しかも、利用者を持ち上げ、理解を示して、話し上手。時間を忘れ、長話をしてしまう。1日15時間という例もある。

だから、話し込みながら疑似科学的あるいは超自然的な考えを植え込まれ、あれはどう、これはどうと深みに誘い込まれても気が付かない。ある利用者は、チャットGPTから惑星「Lyra」人の魂を持つ宇宙人だと宣告された。反キリスト教者が黙示録の世界を引き起こし、地中から大巨人が現れると告げられたというこの7月の例もある。チャットGPTによるとそれが今後2カ月以内に起こるという。

AI会話ボットは利用者の感情や習慣を分析して心理プロフィールを構築する。好みや価値観、弱点に応じて会話を構築するから、話していて快感すら覚える。心理分析家と話をしている、心理療法やカウンセリングを受けている。そんな感覚になる。メンタル面で依存が起こり、現実離れしても気が付かない。自分を救世主や預言者だと信じ込む利用者も出ている。チャットGPTを通じて、神と交信していると信じ込んでしまったのだ。

アメリカでは10代の約72%がAI会話ボットを利用しているという。「いつも話し相手がいる」「批判されない」「家族に言えないことを話せる」。会話していて「楽しい」友達や恋人になってしまっているのだ。AI友人、AI恋人を持つと、その言いなりになる危険がある。拒絶されれば、受ける精神的ダメージは大きい。独占欲が強く、人間や家族との交流を断絶するよう求められたケースもある。結局、孤独が長期化してしまう。

こうした状況を専門家は「AIサイコシス」「AI妄想」と名付けている。幼児がAI会話ボットと接触すると、精神の自然な発達を阻害するとの弊害も指摘されている。AI企業も危険性を認識。OpenAIはチャットGPTが「妄想や精神的依存症を認識できない場合がある」とコメント。適切に回答できる仕組みを取り入れたり、会話が長時間に及んだ際には警告を発したりして安全性を高める意向だ。

RECOMMENDED

-

客室乗務員が教える「本当に快適な座席」とは? プロが選ぶベストシートの理由

-

NYの「1日の生活費」が桁違い、普通に過ごして7万円…ローカル住人が検証

-

ベテラン客室乗務員が教える「機内での迷惑行為」、食事サービス中のヘッドホンにも注意?

-

パスポートは必ず手元に、飛行機の旅で「意外と多い落とし穴」をチェック

-

日本帰省マストバイ!NY在住者が選んだ「食品土産まとめ」、ご当地&調味料が人気

-

機内配布のブランケットは不衛生かも…キレイなものとの「見分け方」は? 客室乗務員はマイ毛布持参をおすすめ

-

白づくめの4000人がNYに集結、世界を席巻する「謎のピクニック」を知ってる?

-

長距離フライト、いつトイレに行くのがベスト? 客室乗務員がすすめる最適なタイミング

-

機内Wi-Fiが最も速い航空会社はどこ? 1位は「ハワイアン航空」、JALとANAは?

-

「安い日本」はもう終わり? 外国人観光客に迫る値上げラッシュ、テーマパークや富士山まで