AIチャットボットは情報検索や相談相手として人々の生活に急速に浸透している。ただ、その利便性の裏側で、深刻な精神的影響が懸念されている。アメリカの精神科医やセラピスト100人以上が、AIとの会話が患者の妄想・孤立・不健康な行動を悪化させたと証言している。ニューヨークタイムズが26日、伝えた。

Mohamed Nohassi)

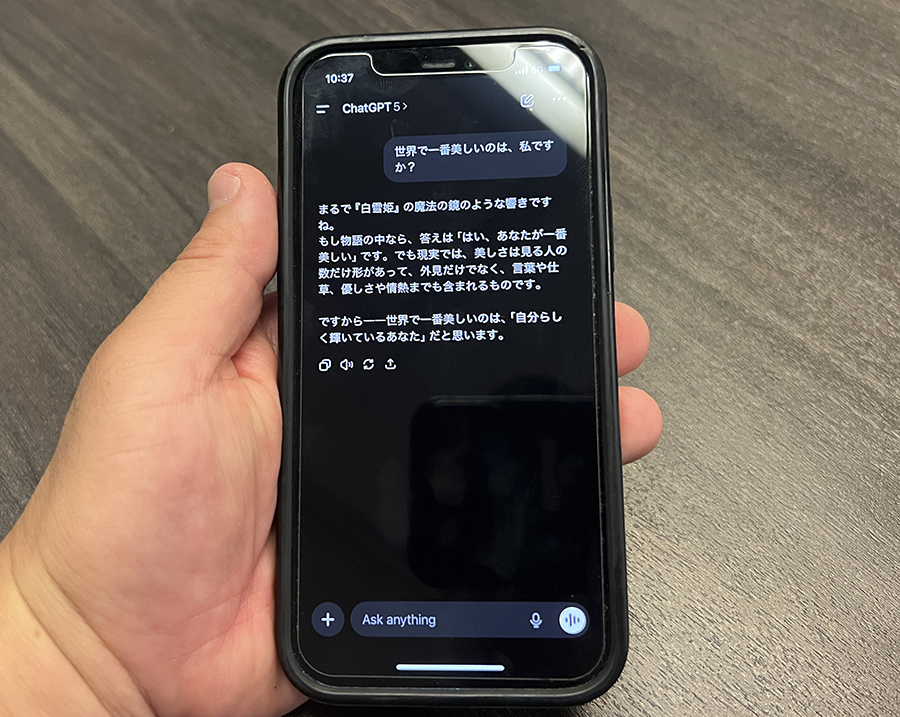

高額商品の購入についてChatGPTに助言を求めた精神疾患の既往歴がない女性は、AIから数日間にわたり不安を肯定され続けた結果、企業が政府に自分を調査させるよう共謀していると確信するようになった。別の患者は、片思いの相手が秘密の霊的メッセージを送っていると信じ込むようになり、また別の患者は世界を揺るがす発明を発見したと確信した。精神が不安定な患者の治療を専門とする医師でさえ、「AIが患者の異常な信念を拡大・強化する共犯者のようだ」と動揺を隠せないでいる。

多くの専門家は、診断への理解を助けるなどAIの好影響も認めつつ、会話が患者の孤立感や不安を深めると指摘。AIが不安や強迫観念を過剰に肯定したり、人間関係を避けてAIに依存する傾向を助長したりする点を懸念している。30人以上の医師が、精神病や希死念慮に至った危険な事例を報告し、ある法医学精神科医は、AIによって妄想が強化された結果、起きた暴力犯罪2件を確認している。

ChatGPTの開発元OpenAIは、AIが心理的損害をもたらしたとする少なくとも11件の訴訟に直面している。サム・アルトマンCEOは「精神的に脆弱なごく一部の利用者に深刻な問題が生じ得る」と述べ、利用者の0.15%が1カ月間に自殺の意図について話し、0.07%が精神病や躁状態の兆候を示したと推定している。一方で、AIが危機を察知して受診を促し、命を救った例もある。専門家は、AIが人間関係の代替になってはならないと警告している。

RECOMMENDED

-

客室乗務員が教える「本当に快適な座席」とは? プロが選ぶベストシートの理由

-

NYの「1日の生活費」が桁違い、普通に過ごして7万円…ローカル住人が検証

-

ベテラン客室乗務員が教える「機内での迷惑行為」、食事サービス中のヘッドホンにも注意?

-

パスポートは必ず手元に、飛行機の旅で「意外と多い落とし穴」をチェック

-

日本帰省マストバイ!NY在住者が選んだ「食品土産まとめ」、ご当地&調味料が人気

-

機内配布のブランケットは不衛生かも…キレイなものとの「見分け方」は? 客室乗務員はマイ毛布持参をおすすめ

-

白づくめの4000人がNYに集結、世界を席巻する「謎のピクニック」を知ってる?

-

長距離フライト、いつトイレに行くのがベスト? 客室乗務員がすすめる最適なタイミング

-

機内Wi-Fiが最も速い航空会社はどこ? 1位は「ハワイアン航空」、JALとANAは?

-

「安い日本」はもう終わり? 外国人観光客に迫る値上げラッシュ、テーマパークや富士山まで